前段時間ChatGPT的出圈,掀起了新一輪AI技術熱潮,也帶火了AI大模型。在這種熱潮下,算力需求爆發成為一個重要的話題。

根據相關機構的預估,到2030年,全球算力規模將是2021年的28倍,其中智能算力將占總算力的94%,是基礎算力總量的16倍。

全新的趨勢也引發了新的思考:

· 面對智能算力的爆發式增長,數字基礎設施如何滿足快速增長的高算力需求?

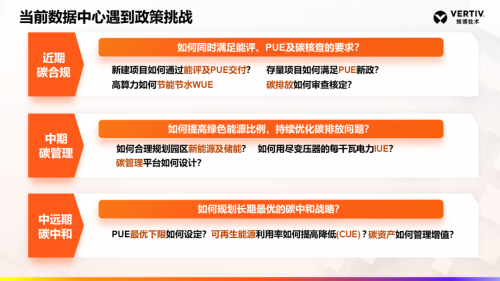

· 作為算力的支撐載體,數據中心又會面臨哪些政策和技術的多項挑戰?

強監管下面臨節能節碳挑戰

近年來,在“東數西算”工程、數字經濟發展、智能計算中心布局的推動下,我國的數據中心保持了20%的持續增長,去年全國平均功率算力比22W/TF,算力增長速度超過了80%。

隨著數據中心規模與功率密度的不斷提高,其能耗問題日益突出。在數據中心面臨的諸多監管中,“東數西算”工程對數據中心的建設標準更為嚴格。

平均上架率至少要達到65%以上

對PUE的要求也更為嚴苛

東部數據中心集群平均PUE小于1.25

西部地區平均PUE小于1.2……

與以往不同的是,對數據中心的監管政策開始兼顧碳使用效率(CUE),在強調節能的同時,要求提升可再生能源使用率,減少用水或無水運行,以此驅動數據中心向高智能、高算力、節能節水、低碳環保的方向發展。

PCUE、SPUE技術難題如何尋解

在落實節能減碳之外,為滿足AI大模型算力需求,數據中心還要面對如何提高單位算力的難題。化解這個難題,一方面需要提高單柜功率密度,另一方面需要降低功率算力比,用最少的瓦數實現最大的算力。

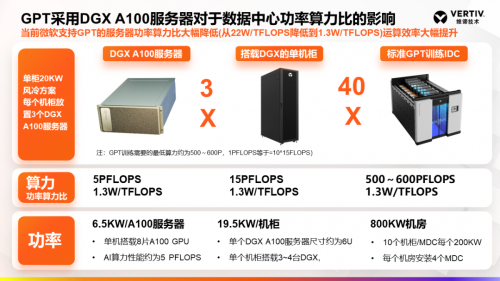

微軟通過采用算力性能高達5 PFLOPS的英偉達DGX A100服務器,將單柜功率密度提高了3~4倍。其每個機柜放置3臺DGX A100服務器,功率達到20 kW,大幅降低了功率算力比,從22W/TFLOPS降到1.3W/TFLOPS,實現了運算效率的提升。

在微軟支持GPT的數據中心中,制冷采用的是風冷解決方案。相對而言,浸沒式液冷在安全性、穩定性上還存在一些問題,比如,礦物油易燃、氟化液成本高、元器件與冷卻液需要做兼容測試等等,不能有效應對數據中心的高溫挑戰。

此外,盡管通過在機架上多部署服務器可以解決功率密度問題,但是電力系統占地面積也會大幅激增,最終會面臨如何擺放的問題。就此而言,AI大模型算力的發展,在技術層面也對數據中心的功率算力使用效率(PCUE)、空間使用效率(SPUE)提出了挑戰。

維諦技術2023關鍵行動計劃

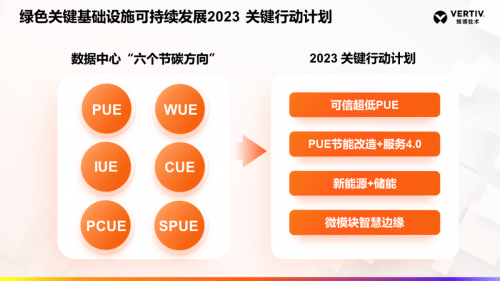

在維諦技術(Vertiv,NYSE:VRT)看來,數據中心所面臨的挑戰,也代表了綠色關鍵基礎設施可持續發展的六個方向,需要根據不同的發展階段,制定關鍵基礎設施可持續發展戰略。

基于相應的戰略,維諦技術(Vertiv)圍繞供配電、制冷、管理等維度,在產品、技術層面提供具體的實施路徑與落地實踐。

近期:通過提供動態在線UPS、全變頻氟泵空調、能耗管理等方案,打造超低PUE。

中期:通過提供儲備一體化UPS、儲能空調、AI節能管理等方案,實現新能源和儲能的交付。

中遠期:通過提供固態變壓器、氫燃料電池發電、熱回收裝置、碳管理,落地微電網和高密度算力。

目前,維諦技術(Vertiv)基于綠色關鍵基礎設施可持續發展的節碳方向,在2023關鍵行動計劃中,重點聚焦可信超低PUE、PUE節能改造+服務4.0、新能源+儲能以及微模塊智慧邊緣解決方案的交付落地。

AI時代,高算力已經成為大模型應用的關鍵保障。維諦技術(Vertiv)將以不斷的技術創新化解行業挑戰,從全生命周期角度打造端到端的綠色低碳數據中心,為AI技術發展夯實算力底座。